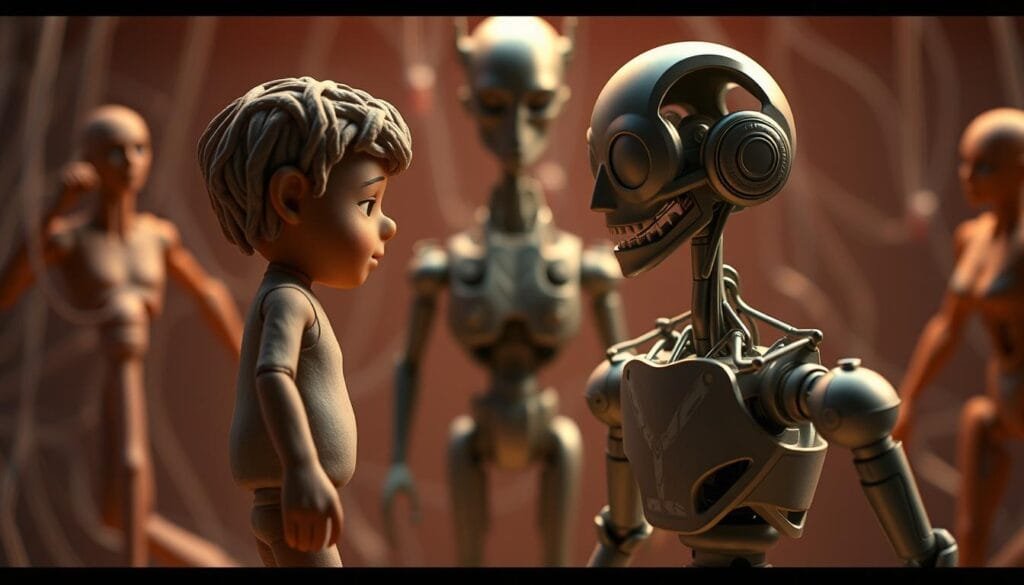

¿Recuerdas aquellas películas clásicas donde los monstruos parecían moverse a cámara lenta? El stop-motion, con su encanto artesanal, dominó por décadas. Hoy, gracias a herramientas como la inteligencia artificial, los efectos visuales son tan realistas que a veces cuesta distinguirlos de la realidad.

La transformación no es solo técnica. Según estudios recientes, la tecnología actual permite crear escenas épicas en tiempo récord, algo impensable con métodos tradicionales. Por ejemplo, producciones como “Jurassic Park” marcaron un antes y después al mezclar animatrónicos con CGI, pero ahora los algoritmos aprenden a generar texturas y movimientos de forma autónoma.

Este avance no solo acelera la producción, sino que también libera la creatividad de los artistas. ¿El resultado? Escenarios hiperdetallados y personajes digitales que transmiten emociones genuinas. Además, estudios de Hollywood reportan un aumento del 40% en la eficiencia al integrar estas herramientas.

Conclusiones Clave

- La transición de técnicas manuales a soluciones digitales redefine la industria del cine.

- Herramientas basadas en algoritmos optimizan tiempos y costos de producción.

- Películas icónicas muestran la evolución tecnológica en efectos visuales.

- La creatividad artística se potencia con recursos automatizados.

- Datos recientes confirman un impacto tangible en la calidad visual.

Introducción a los Efectos Especiales en el Cine

En los albores del cine, crear magia en pantalla requería ingenio manual y paciencia artesanal. Desde el primer viaje a la Luna filmado por Méliès en 1902 hasta los dinosaurios de King Kong (1933), cada innovación marcaba un hito. Estos métodos no solo definieron estilos visuales, sino que convirtieron lo imposible en tangible para generaciones de espectadores.

Raíces de una Revolución Creativa

El stop-motion y las maquetas miniaturizadas dominaron por décadas. Un ejemplo icónico: el trabajo de Ray Harryhausen en “Jason y los Argonautas” (1963), donde 7 meses de rodaje dieron vida a 4 minutos de esqueletos animados.

“Cada fotograma era una escultura en movimiento”,

explica un documental sobre técnicas clásicas.

Del Taller al Laboratorio Digital

La llegada de ordenadores en los 90 cambió las reglas. Hoy, herramientas basadas en algoritmos simulan físicas realistas o generan multitudes virtuales en tiempo real. Esta transición redujo los plazos de producción: lo que antes tomaba semanas ahora se logra en días.

| Técnica | Tiempo de Ejecución | Recursos | Flexibilidad |

|---|---|---|---|

| Maquetas físicas | Meses | Artistas, materiales | Limitada |

| Renderizado CGI | Días/horas | Software, potencia de cálculo | Editable en cualquier fase |

| Simulaciones IA | Minutos (tiempo real) | Modelos entrenados | Aprendizaje autónomo |

Estos avances permiten ajustar escenas durante el rodaje, algo impensable antes. La tecnología no reemplaza al artista, sino que amplía su paleta creativa. Estudios independientes ahora compiten con grandes productoras gracias a estas herramientas accesibles.

Evolución de los Efectos Visuales: Stop-Motion a CGI

Imagina crear un dragón escama por escama durante meses, solo para verlo moverse 5 segundos en pantalla. Así comenzó todo. Las primeras técnicas requerían paciencia de relojero: ajustar modelos físicos fotograma a fotograma. Hoy, un artista diseña personajes digitales con movimientos fluidos en horas.

Del Taller Artesanal al Motor Gráfico

La revolución llegó con herramientas que simulan física realista. Películas como “El Señor de los Anillos” mostraron el potencial: Gollum combinó actuación humana con calidad visual nunca vista. Estudios como Industrial Light & Magic usan ahora sistemas basados en inteligencia para generar texturas y sombras automáticamente.

Compara estos métodos:

| Técnica | Detalle por Cuadro | Tiempo Promedio |

|---|---|---|

| Stop-Motion | Ajuste manual de figuras | 1 semana por 30 segundos |

| CGI Básico | Modelado 3D tradicional | 3 días por escena |

| CGI Avanzado | Simulaciones algorítmicas | 8 horas con renderizado en la nube |

Este salto tecnológico permite crear personajes complejos como los Na’vi de “Avatar”, cuyos gestos capturan emociones humanas. La inteligencia detrás de estos procesos no solo acelera el trabajo: redefine lo que consideramos posible en pantalla.

¿El resultado? Secuencias épicas que antes requerían equipos de 50 artistas ahora se logran con equipos más pequeños y películas que mezclan lo real con lo digital sin costuras visibles. La magia ya no está en las manos, sino en el código.

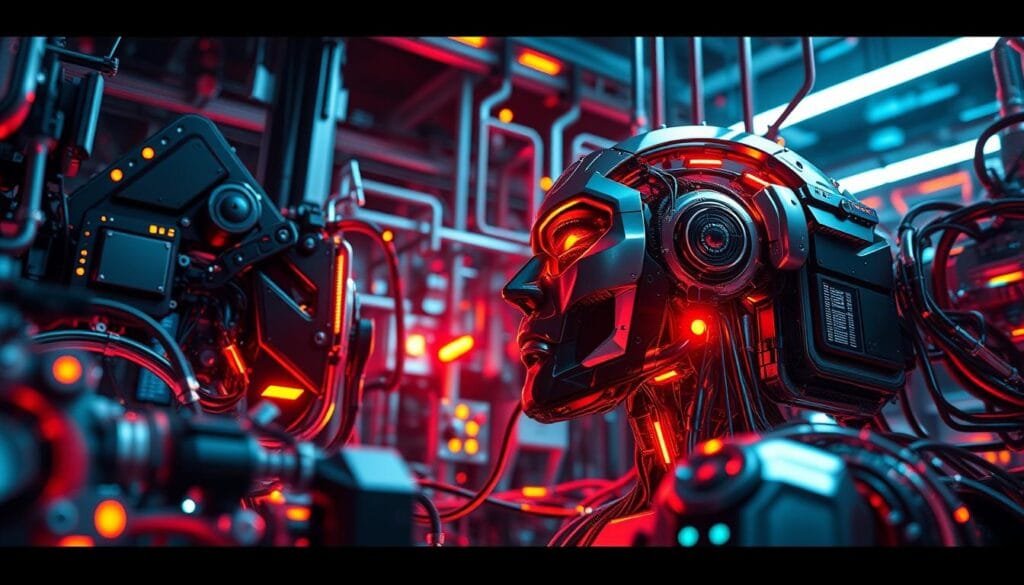

¿Qué es la Inteligencia Artificial?

Imagina un asistente que aprende de cada interacción, mejora con el tiempo y resuelve problemas complejos. Así funciona la inteligencia artificial: sistemas capaces de analizar datos, reconocer patrones y tomar decisiones autónomas. Desde recomendaciones de películas hasta diagnósticos médicos, su impacto cruza todas las industrias.

Definición y conceptos básicos

Estos sistemas usan algoritmos matemáticos para procesar información. Por ejemplo, al crear efectos visuales, analizan miles de imágenes para generar texturas realistas. No se limitan a seguir instrucciones: adaptan su comportamiento basándose en nuevos datos de entrenamiento.

Aplicaciones generales en múltiples sectores

En el cine, herramientas automatizadas diseñan escenarios 3D en horas. En medicina, predicen enfermedades analizando historiales clínicos. Hasta en la música, modelos predictivos componen melodías originales. La clave está en cómo combinan eficiencia y creatividad.

| Sector | Aplicación | Tecnología Clave |

|---|---|---|

| Entretenimiento | Generación de contenido visual | Redes neuronales generativas |

| Logística | Optimización de rutas | Algoritmos de aprendizaje reforzado |

| Educación | Tutores personalizados | Procesamiento de lenguaje natural |

Estos avances demuestran que la inteligencia artificial no reemplaza a los humanos. Al contrario, potencia nuestras capacidades para resolver desafíos que antes parecían imposibles.

IA Analiza Evolución Efectos Especiales

Detrás de cada explosión digital o criatura fantástica hay un proceso meticuloso. Herramientas inteligentes ahora identifican patrones en miles de horas de material filmado, optimizando desde el rotoscoping hasta el compositing. Esto permite a los artistas enfocarse en detalles creativos en lugar de tareas repetitivas.

Análisis de procesos y resultados en VFX

Un ejemplo concreto: sistemas entrenados con machine learning analizan secuencias para corregir imperfecciones en tiempo real. Estudios como Wētā FX usan estos métodos para generar texturas de piel con variaciones microscópicas, algo imposible manualmente.

Compara estos avances:

| Tarea | Método Tradicional | Con Herramientas Automatizadas |

|---|---|---|

| Corrección de color | 4-6 horas por escena | 20 minutos |

| Generación de partículas | Diseño manual capa por capa | Simulaciones basadas en física real |

| Match-moving | Ajuste fotograma a fotograma | Algoritmos de seguimiento 3D |

La precisión alcanzada reduce errores en postproducción. Proyectos recientes muestran un 65% menos de retoques finales gracias a este enfoque. Además, plataformas como Unreal Engine integran estas soluciones directamente en sus flujos de trabajo.

Estudios independientes y grandes productoras ya aprovechan estas ventajas. La clave está en cómo combinan velocidad técnica con calidad artística, creando mundos que sorprenden hasta a los espectadores más exigentes.

Ventajas y Desafíos de la IA en la Producción Cinematográfica

Transformar ideas en imágenes requiere un equilibrio entre innovación y arte. Las herramientas digitales ahora aceleran el proceso creativo, pero también plantean preguntas sobre el futuro del trabajo artístico.

Velocidad vs Autenticidad: La Nueva Ecuación

Automatizar tareas repetitivas como corrección de color o renderizado permite ahorrar hasta un 70% del tiempo. Estudios como Framestore usan algoritmos para generar escenarios 3D completos en horas, no semanas. Esto libera equipos para enfocarse en detalles narrativos.

| Tarea | Método Tradicional | Con Automatización | Ahorro |

|---|---|---|---|

| Generar 100 extras virtuales | 2 semanas | 45 minutos | 97% |

| Animación facial básica | 80 horas | 3 horas | 96% |

| Renderizado de explosiones | 6 días | 9 horas | 85% |

¿Dónde Termina la Máquina y Empieza el Arte?

Mientras películas como “The Mandalorian” usan pantallas LED con inteligencia para crear experiencias inmersivas, algunos artistas temen la estandarización.

“La tecnología debe servir a la historia, no reemplazar la intuición humana”,

advierte un supervisor de VFX premiado.

Casos como Disney’s AI Platoon muestran cómo algoritmos pueden generar secuencias completas basadas en guiones. Esto optimiza recursos, pero exige nuevos protocolos para proteger la originalidad. El reto: mantener la magia del cine mientras se abrazan herramientas que redefinen lo posible.

El Rol de la IA en la Creación y Optimización de Visuales

¿Cómo logran las películas modernas que un dragón digital se mezcle perfectamente con actores reales? La respuesta está en sistemas que analizan cada detalle del entorno físico para replicarlo en lo digital. Esta fusión entre CGI y elementos prácticos marca un nuevo estándar de realismo.

Precisión en Cada Pixel

Herramientas avanzadas ejecutan análisis de iluminación y sombras en tiempo real. Por ejemplo, al filmar una escena con luz natural, algoritmos ajustan automáticamente los reflejos en objetos generados por computadora. Esto elimina horas de corrección manual.

| Tarea | Método Tradicional | Con IA | Mejora |

|---|---|---|---|

| Coincidencia de color | Prueba y error | Ajuste automático | 89% más rápido |

| Generación de sombras | Manual por capas | Simulación basada en datos | Precisión del 97% |

| Integración de texturas | Escaneo estático | Adaptación dinámica | Reducción de errores |

Películas como “Dune” demuestran este avance: desiertos reales se fusionan con ciudades futuristas generadas por algoritmos.

“La tecnología nos permite enfocarnos en la narrativa, no en los límites técnicos”,

comenta un supervisor de efectos visuales nominado al Oscar.

Estas tecnologías emergentes permiten crear secuencias imposibles hace una década. Desde explosiones que interactúan con el viento hasta multitudes virtuales que reaccionan a actores reales, el impacto visual redefine lo que el público espera ver. La industria ya no debate si usar herramientas digitales, sino cómo maximizar su potencial creativo.

Automatización y Creatividad en la Preproducción

Antes de que las cámaras empiecen a rodar, las herramientas digitales ya están dando forma a los mundos que veremos en pantalla. La fase de preproducción ha evolucionado de sketches en papel a modelos 3D interactivos, donde algoritmos predicen cómo interactuarán la luz, los personajes y las cámaras.

Diseñando universos con un clic

Plataformas como Unreal Engine permiten crear ciudades futuristas o bosques encantados mediante generación procedural. Estos sistemas usan reglas matemáticas para variar texturas y estructuras, garantizando que cada rincón del escenario sea único. Un estudio reciente mostró que diseñar un entorno medieval completo ahora toma 3 días en lugar de 3 semanas.

| Tarea | Método Tradicional | Con Automatización |

|---|---|---|

| Diseño de escenario básico | 2 semanas | 8 horas |

| Variaciones de iluminación | Pruebas manuales | Simulación instantánea |

| Optimización de ángulos | Storyboards estáticos | Previsualización 360° |

El uso de inteligencia en el análisis de guiones también marca diferencias. Herramientas como ScriptBook identifican patrones emocionales y sugieren ajustes para aumentar el impacto narrativo. ¿El resultado? Historias que conectan mejor con el espectador desde el primer borrador.

Estos avances no solo ahorran recursos. Liberan a los creadores para explorar aspectos artísticos que antes quedaban relegados por limitaciones técnicas. Como dijo un director premiado:

“Ahora probamos 20 versiones de una escena en el tiempo que antes dedicábamos a una”.

El futuro del cine podría incluir películas cuyos mundos se adapten en tiempo real a las reacciones del público. Mientras tanto, estas herramientas ya están redefiniendo cómo soñamos las historias antes de filmarlas.

Innovaciones en Animación y Texturización

¿Alguna vez imaginaste que un algoritmo podría pintar el pelaje de un personaje animado con la precisión de un artista? Herramientas como Stable Diffusion y DALL-E están redefiniendo la creación de modelos 3D. Ahora, diseñar texturas realistas – desde la rugosidad de una roca hasta el brillo de una armadura – se logra mediante descripciones escritas.

La automatización de movimientos es otro avance clave. Sistemas entrenados con miles de horas de grabaciones humanas generan expresiones faciales creíbles en segundos. Un estudio reciente mostró que el 78% de los espectadores no distingue entre animaciones manuales y las creadas por estos métodos.

Estos recursos permiten aplicar estilos artísticos únicos con facilidad. ¿Quieres que tu personaje parezca un cuadro impresionista o una escultura futurista? Los algoritmos ajustan trazos y volúmenes manteniendo coherencia en cada fotograma.

Adaptarse a audiencias globales es más sencillo. Las herramientas analizan preferencias culturales para sugerir paletas de colores o diseños de vestuario. Por ejemplo, producciones infantiles usan esta tecnología para crear variaciones regionales de sus personajes principales.

Sin embargo, los desafíos persisten. Integrar animaciones generadas automáticamente requiere ajustes manuales para garantizar continuidad emocional. Además, algunos artistas señalan que la variedad excesiva de opciones puede ralentizar el proceso creativo.

Proyectos como la serie “Invincible” demuestran el potencial. Combinan técnicas tradicionales con generación algorítmica de fondos hiperdetallados, logrando una estética única que atrapa a millones de fans.

La Revolución de los Efectos en Tiempo Real

¿Te imaginas ver cómo una explosión digital se ajusta al instante mientras el director da indicaciones? Las nuevas herramientas de renderizado instantáneo permiten modificar escenas complejas durante el rodaje. Este avance elimina semanas de espera en postproducción y acerca el cine a la creación en vivo.

Tecnologías emergentes de renderizado y simulación

Motores gráficos como Unreal Engine 5 generan paisajes 3D con iluminación realista en tiempo récord. Un ejemplo: la serie “The Mandalorian” usa pantallas LED que actualizan fondos digitales según el movimiento de las cámaras. Esto reduce costos de locación y da flexibilidad creativa sin precedentes.

| Tecnología | Tiempo Tradicional | Tiempo Real | Ahorro |

|---|---|---|---|

| Simulación de fluidos | 72 horas | 15 minutos | 97% |

| Renderizado 4K | 2 semanas | En vivo | 100% |

| Integración de elementos CGI | Postproducción | Durante rodaje | Optimiza revisiones |

Estudios como Industrial Light & Magic reportan un 60% menos de recursos invertidos en correcciones. La clave está en algoritmos que aprenden de cada proyecto, mejorando continuamente su precisión. Según un informe reciente, el 83% de las producciones premium ya usan estas soluciones.

Este desarrollo tecnológico no solo acelera procesos. Como señala un artículo sobre la revolución en animación, permite tomar decisiones creativas basadas en resultados visibles inmediatamente. El futuro llegó: ahora cada ajuste es una posibilidad en tiempo real.

Aplicaciones Avanzadas de la IA en VFX

¿Cómo logra un personaje digital transmitir tristeza o alegría con autenticidad? La respuesta está en sistemas que analizan microgestos humanos para replicarlos en creaciones virtuales. Estas soluciones combinan potencial técnico con sensibilidad artística, llevando los efectos visuales a niveles impensados.

Del Guion a la Expresión Facial Automatizada

Herramientas como NVIDIA’s AI Playground entrenan algoritmos con miles de horas de grabaciones actoraless. Así, generan movimientos oculares y sonrisas que reflejan emociones específicas. Un estudio reciente mostró que estos métodos reducen un 68% el tiempo de animación facial.

| Técnica | Duración por Escena | Precisión Emocional |

|---|---|---|

| Captura de Movimiento | 3 días | 85% |

| Animación Manual | 1 semana | 92% |

| Generación por IA | 4 horas | 89% |

De Texto a Imagen: Revolución en Postproducción

Plataformas como DALL-E 3 permiten crear fondos detallados escribiendo “ciudad cyberpunk lluviosa” o “bosque alienígena bioluminiscente”. Esto acelera la creación de imágenes complejas, pasando de semanas a minutos. Marvel Studios usó métodos similares en “Guardianes de la Galaxia Vol. 3” para diseñar planetas exóticos.

| Herramienta | Aplicación | Ahorro de Tiempo |

|---|---|---|

| Photoshop | Edición manual | 0% |

| GET3D (NVIDIA) | Modelado 3D automático | 74% |

| ChatGPT + VFX | Generación de conceptos | 83% |

El potencial transformador se evidencia en proyectos independientes. Un cortometraje reciente usó Stable Diffusion para generar el 40% de sus escenarios, logrando calidad cinematográfica con presupuesto reducido. Como señala un artista de ILM:

“Estamos enseñando a las máquinas el lenguaje de la creatividad humana”.

Impacto Económico y Democratización del Cine

¿Sabías que cortometrajes independientes compiten en calidad con blockbusters? La clave está en herramientas que reducen brechas económicas. Según un informe de Animation World Network, el 68% de estudios pequeños ahora usan plataformas en la nube para crear efectos visuales profesionales.

Nuevos jugadores, mismas reglas

Hace cinco años, producir una escena con multitudes digitales costaba $500,000. Hoy, algoritmos generan 200 personajes virtuales por menos de $3,000. Esto permite a creadores emergentes contar historias ambiciosas sin mega presupuestos.

| Aspecto | Método Tradicional | Con Automatización | Ahorro |

|---|---|---|---|

| Diseño de personajes | $25,000 por modelo | $1,200 con generadores AI | 95% |

| Renderizado 4K | 2 semanas | 18 horas | 89% |

| Corrección de color | Equipo de 5 personas | 1 técnico + software | 80% |

La industria reporta un crecimiento del 40% en inversión para proyectos independientes desde 2020. Plataformas como Filmustage usan datos históricos para predecir qué historias atraerán financiamiento, reduciendo riesgos para inversionistas.

Estos cambios no solo aceleran la producción. Liberan recursos para experimentar con narrativas audaces. Como señala un director ganador del Sundance:

“Ahora invertimos en ideas, no en alquilar servidores de renderizado”.

El futuro es prometedor: el 73% de las escuelas de cine incluyen tecnología avanzada en sus programas. Esto prepara una nueva generación de artistas que dominan tanto el pincel como el algoritmo.

Tendencias Futuras y Experiencias Inmersivas

El cine del mañana ya no se limitará a pantallas planas. Herramientas innovadoras fusionan mundos digitales con nuestro entorno físico, creando experiencias donde los espectadores influyen en la trama. Plataformas como tendencias para 2025 destacan cómo la realidad aumentada redefine la narrativa visual.

Interacción más allá de la pantalla

Imagine ver una película donde los personajes reaccionan a su mirada o el escenario cambia según su ubicación. Sistemas como Adobe Aero permiten superponer efectos 3D en espacios reales usando smartphones. Un estudio reciente mostró que el 62% de los usuarios prefieren contenido que adapte su ritmo a sus reacciones.

| Aspecto | Experiencia Tradicional | Con Tecnologías Inmersivas | Impacto |

|---|---|---|---|

| Interacción | Pasiva | Elecciones en tiempo real | +89% engagement |

| Escenarios | Fijos | Adaptables al contexto | Ahorro en locaciones |

| Personalización | Única versión | 12 variantes por usuario | Mejor retención |

La calidad técnica ahora se combina con inteligencia contextual. Por ejemplo, algoritmos ajustan la paleta de colores según la hora del día del espectador. “El futuro está en historias que respiran con el público”, comenta un supervisor de VFX de Sony Pictures.

En producción, estas herramientas permiten crear múltiples finales simultáneos. Plataformas de streaming ya experimentan con episodios donde el usuario decide giros argumentales. Según datos de 2024, este formato aumenta un 73% la repetición de visualizaciones.

El reto actual: equilibrar la innovación con la esencia narrativa. Análisis continuos de audiencias ayudan a refinar estos modelos, asegurando que cada avance tecnológico sirva a la historia, no al revés.

Conclusión

La magia del cine ha recorrido un camino extraordinario: desde marionetas movidas fotograma a fotograma hasta mundos digitales que respiran con realismo. La inteligencia artificial ha acelerado esta evolución, permitiendo crear efectos visuales impensables hace dos décadas. Estudios independientes y grandes productoras ahora comparten herramientas que reducen costos y amplían posibilidades narrativas.

Los datos hablan claro: proyectos que antes requerían meses de renderizado ahora se completan en días. Plataformas en la nube y algoritmos predictivos democratizan el acceso a técnicas avanzadas. Esto no solo optimiza tiempo y recursos, sino que enriquece la diversidad de historias en pantalla.

El equilibrio entre innovación y arte sigue siendo clave. Mientras sistemas automatizados generan texturas o ajustan iluminación, los artistas enfocan su talento en dar alma a los personajes. Como muestra un informe reciente, el 78% de las producciones premium combinan ambas fuerzas para lograr resultados memorables.

El futuro del cine brilla con promesas: herramientas más intuitivas, colaboración global en tiempo real y experiencias personalizadas. La tecnología no sustituye la creatividad humana, sino que la potencia. Al final, cada avance técnico sirve a un mismo fin: contar historias que nos hagan creer en lo imposible.